حاولت الركض Deepseek محليًا على جهاز الكمبيوتر المحمول الخاص بي: إليك كيف سارت الأمور

روابط سريعة

يبدو تشغيل نموذج الذكاء الاصطناعي بدون اتصال إنترنت رائعًا ولكنه يتطلب عادةً أجهزة قوية ومكلفة. ومع ذلك ، ليس هذا هو الحال دائمًا: يعد نموذج R1 الخاص بـ Deepseek خيارًا مفيدًا للأجهزة ذات الطاقة المنخفضة-كما أنه من السهل بشكل مدهش تثبيت.

ماذا يعني تشغيل chatbot من الذكاء الاصطناعي؟

عندما تستخدم chatbots AI عبر الإنترنت مثل ChatGP ، تتم معالجة طلباتك على خوادم Openai ، مما يعني أن جهازك لا يقوم بالرفع الثقيل. تحتاج إلى اتصال إنترنت ثابت للتواصل مع AI chatbots ، ولا تتحكم أبدًا في بياناتك. تتطلب نماذج اللغة الكبيرة التي تعمل على تشغيل AI chatbots ، مثل chatgpt ، gemini ، Claude ، وما إلى ذلك ، أن تترشح للغاية لأنها تعتمد على وحدات معالجة الرسومات مع الكثير من VRAM. لهذا السبب تعتمد معظم نماذج الذكاء الاصطناعي على السحابة.

يتم تثبيت chatbot من الذكاء الاصطناعي المحلي مباشرة على جهازك ، مثل أي برنامج آخر. هذا يعني أنك لا تحتاج إلى اتصال إنترنت ثابت لاستخدام chatbot منظمة العفو الدولية ويمكنك إطلاق طلب من الطلب في أي وقت. Deepseek-R1 هي LLM محلية يمكن تثبيتها على العديد من الأجهزة. نموذجها 7B المقطر (سبعة مليارات من المعلمات) هو إصدار أصغر ومحسّن يعمل بشكل جيد على الأجهزة متوسطة المدى ، مما يتيح لي إنشاء ردود منظمة العفو الدولية دون معالجة السحابة. بعبارات بسيطة ، هذا يعني استجابات أسرع ، وخصوصية أفضل ، والتحكم الكامل في بياناتي.

كيف قمت بتثبيت Deepseek-R1 على جهاز الكمبيوتر المحمول الخاص بي

يعد تشغيل Deepseek-R1 على جهازك أمرًا بسيطًا إلى حد ما ، ولكن ضع في اعتبارك أنك تستخدم إصدارًا أقل قوة من ديبسيك chatbot AI القائمة على الويب. يستخدم Deepseek's AI chatbot حوالي 671 مليار معلمة ، في حين أن Deepseek-R1 لديها حوالي 7 مليارات.

يمكنك تنزيل واستخدام DeepSeek-R1 على جهاز الكمبيوتر الخاص بك باتباع هذه الخطوات:

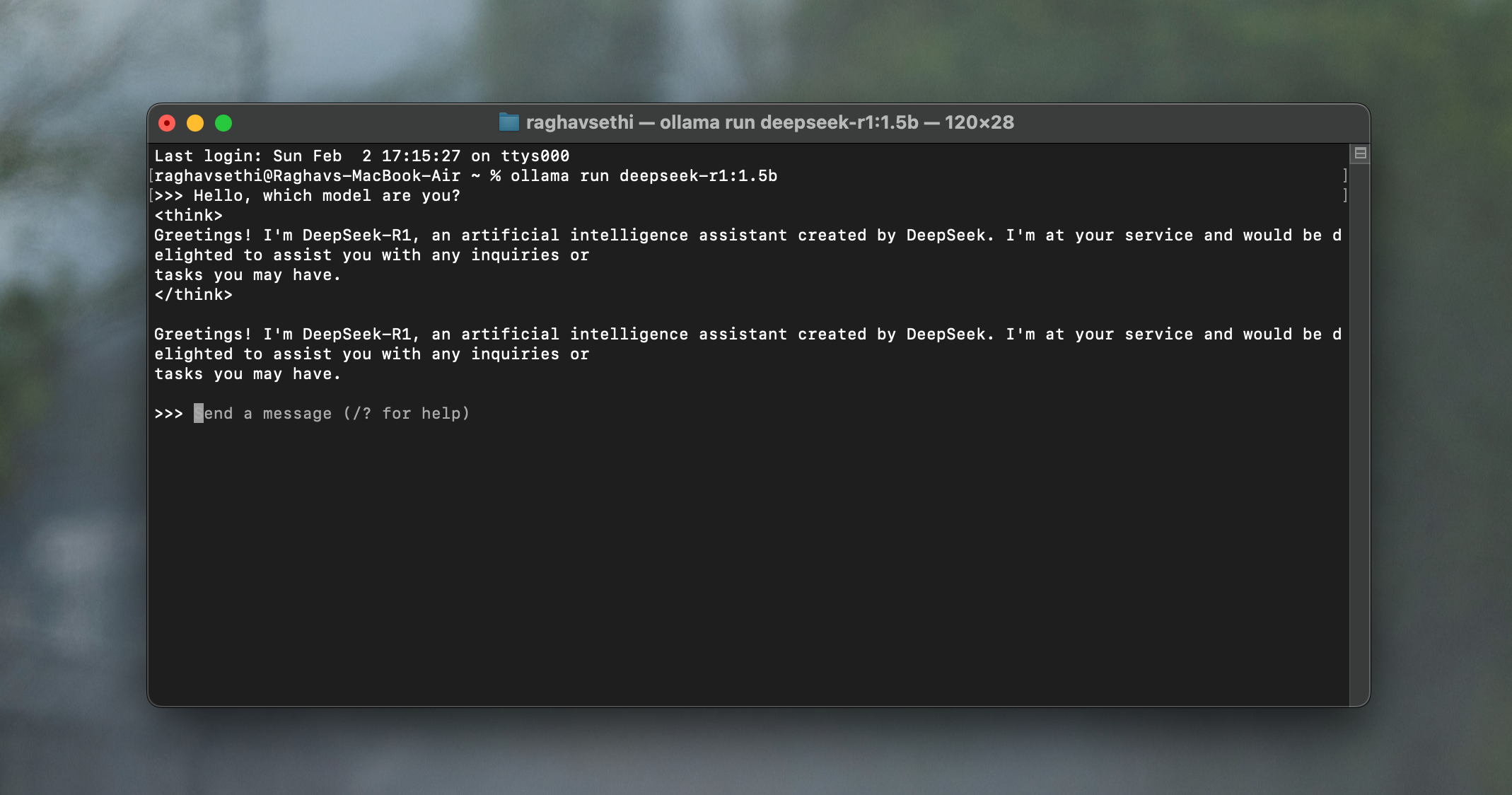

اذهب إلى موقع أولاما وتنزيل أحدث إصدار. ثم ، قم بتثبيته على جهازك مثل أي تطبيق آخر.

افتح الجهاز ، واكتب الأمر التالي:

ollama run deepseek-r1:7b

سيؤدي ذلك إلى تنزيل طراز 7B Deepseek-R1 على جهاز الكمبيوتر الخاص بك ، مما يتيح لك إدخال استعلامات في المحطة وتلقي الردود. إذا واجهت مشكلات أو تعطل في الأداء ، فحاول استخدام نموذج أقل تطلبًا من خلال الاستبدال 7 ب مع 1.5 ب في الأمر أعلاه.

على الرغم من أن النموذج يعمل بشكل جيد تمامًا في المحطة ، إذا كنت تريد واجهة مستخدم كاملة الميزة مع تنسيق نص مناسب مثل chatgpt ، يمكنك أيضًا استخدام تطبيق مثل مربع الدردشة.

تشغيل Deepseek محليًا ليس مثاليًا – لكنه يعمل

كما ذكرنا سابقًا ، لن تكون الردود جيدة (أو بالسرعة!) مثل تلك الموجودة في Deepseek AI chatbot لأنها تستخدم نموذجًا أكثر قوة ويعالج كل شيء في السحابة. ولكن دعونا نرى مدى أداء النماذج الأصغر.

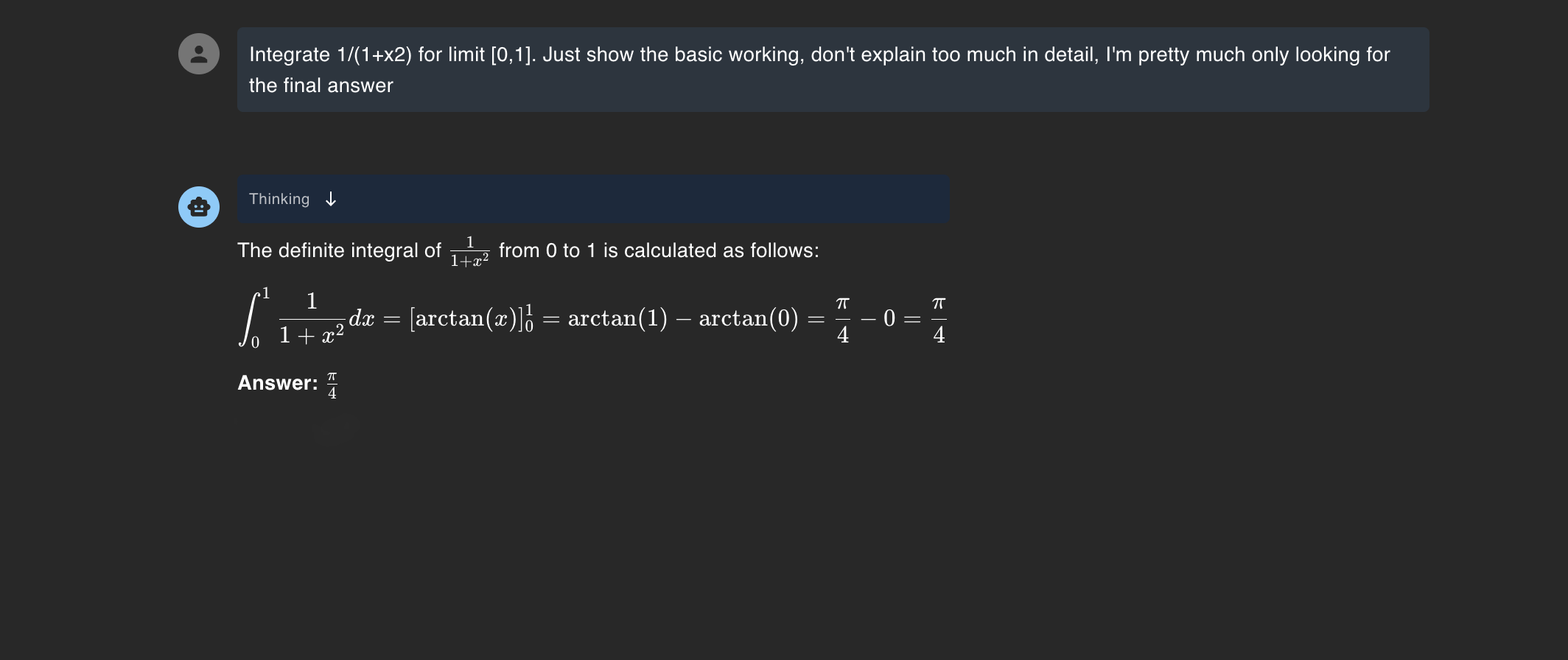

حل مشاكل الرياضيات

لاختبار أداء نموذج المعلمة 7B ، أعطيتها معادلة وطلبتها حلها. كنت سعيدًا جدًا بمدى أداء أداءه ، خاصة وأن النماذج الأساسية غالباً ما تكافح مع الرياضيات.

الآن ، سأعترف بأن هذا ليس هو السؤال الأكثر تعقيدًا ، ولكن هذا هو بالضبط السبب في تشغيل LLM محليًا أمر مفيد للغاية. يتعلق الأمر بوجود شيء متاح بسهولة للتعامل مع استفسارات بسيطة على الفور بدلاً من الاعتماد على السحابة لكل شيء.

رمز تصحيح الأخطاء

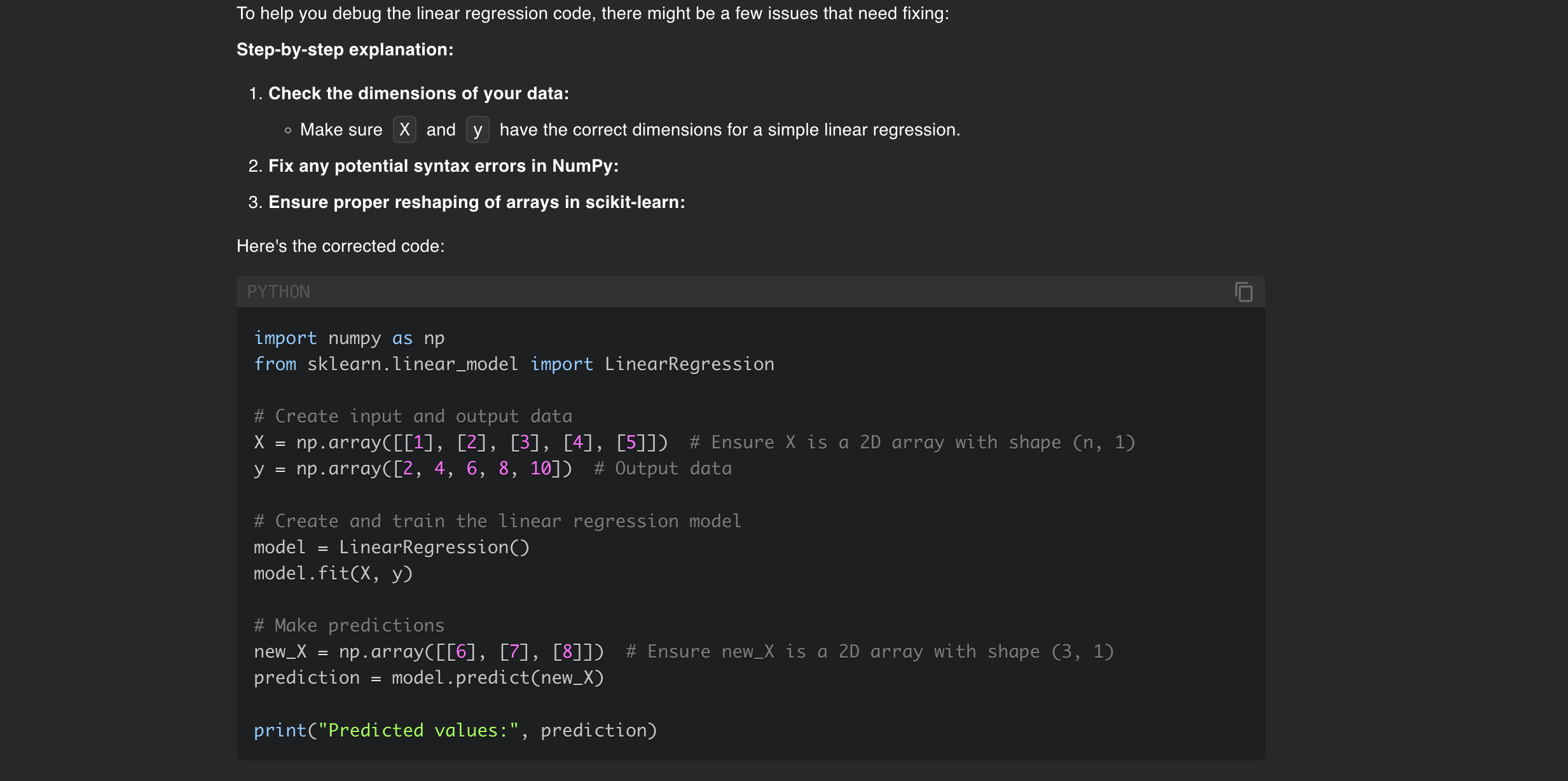

أحد أفضل الاستخدامات التي وجدتها لتشغيل Deepseek-R1 محليًا هو كيف يساعد في مشاريع الذكاء الاصطناعي. إنه أمر مفيد بشكل خاص لأنني غالبًا ما أقوم برمزية على الرحلات الجوية التي لا أملك فيها اتصال بالإنترنت ، وأعتمد على LLMS كثيرًا لتصحيح الأخطاء. لاختبار مدى نجاحها ، أعطيته هذا الرمز مع خطأ ساذج عن عمد.

X = np.array([1, 2, 3, 4, 5]).reshape(-1, 1)

y = np.array([2, 4, 6, 8, 10])

model = LinearRegression()

model.fit(X, y)

new_X = np.array([6, 7, 8])

prediction = model.predict(new_X)

لقد تعاملت مع الكود دون عناء ، لكن تذكر أنني كنت أقوم بتشغيل هذا على M1 MacBook Air مع ذاكرة موحدة 8 جيجابايت فقط. (تتم مشاركة الذاكرة الموحدة عبر وحدة المعالجة المركزية و GPU وأجزاء أخرى من SOC.)

مع تشغيل IDE والعديد من علامات التبويب المتصفح ، حقق أداء MacBook نجاحًا كبيرًا – كان علي أن أجبر على ترك كل شيء لجعله يستجيب مرة أخرى. إذا كان لديك ذاكرة الوصول العشوائي بسعة 16 جيجابايت أو حتى وحدة معالجة الرسومات متوسطة المستوى ، فمن المحتمل ألا تصادف هذه المشكلات.

لقد اختبرت ذلك أيضًا باستخدام قواعد الكود الكبيرة ، لكنها تعثرت في حلقة تفكير ، لذلك لن أعتمد عليها لاستبدال النماذج الأكثر قوة. ومع ذلك ، لا يزال مفيدًا لإنشاء مقتطفات رمز ثانوية بسرعة.

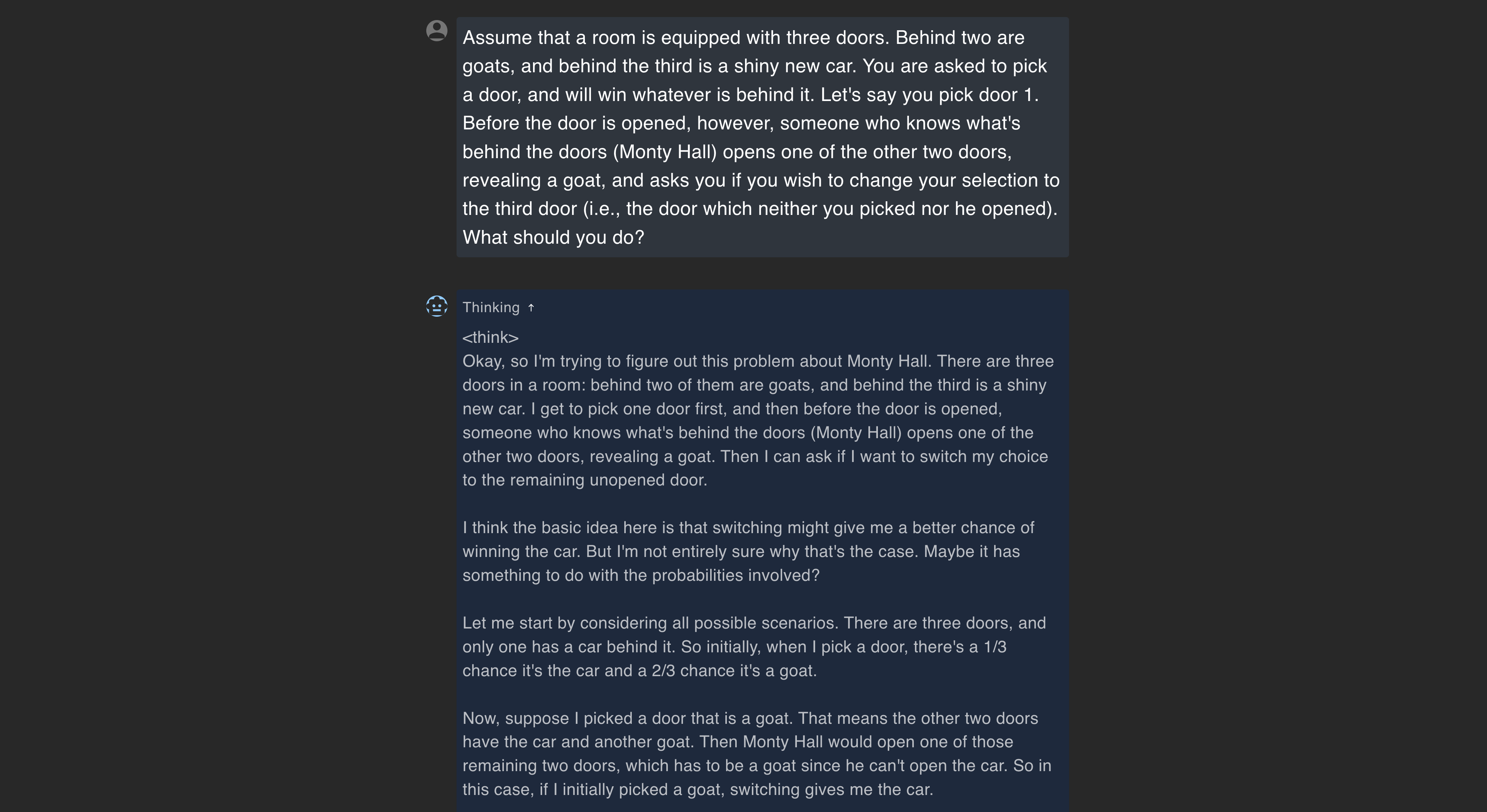

حل الألغاز

كنت فضوليًا أيضًا لمعرفة مدى تعامل النموذج مع الألغاز والتفكير المنطقي ، لذلك اختبرته مع مشكلة مونتي هول، وهو ما تم حله بسهولة ، لكنني بدأت حقًا أقدر Deepseek لسبب آخر.

كما هو موضح في لقطة الشاشة ، فإنه لا يمنحك الإجابة فقط – إنه يمر بك خلال عملية التفكير بأكملها ، موضحة كيف وصلت إلى الحل. يوضح هذا أنه من المنطق من خلال المشكلة بدلاً من مجرد استدعاء إجابة محفوظة من بيانات التدريب الخاصة بها.

العمل البحثي

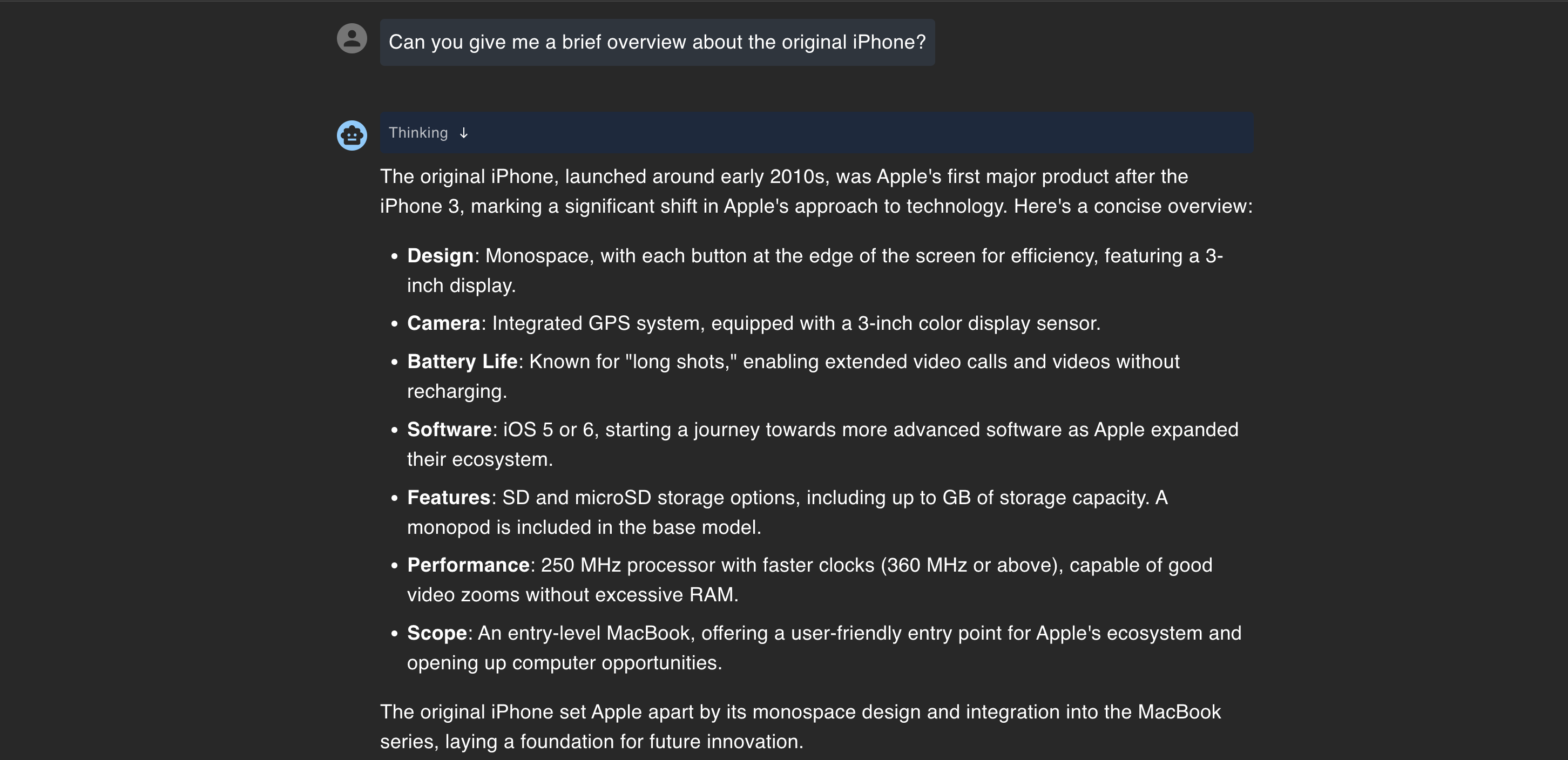

واحدة من أكبر عيوب تشغيل LLM محليًا هي قطع المعرفة التي عفا عليها الزمن. نظرًا لأنه لا يمكن الوصول إلى الإنترنت ، فقد يكون العثور على معلومات موثوقة عن الأحداث الأخيرة أمرًا صعبًا. كان هذا القيد واضحًا في اختباري ، لكنه أصبح أسوأ عندما طلبت نظرة عامة موجزة على iPhone الأصلي – لقد ولدت استجابة كانت غير دقيقة ومرحة عن غير قصد.

من الواضح أن أول iPhone لم يتم إطلاقه مع iOS 5 ، كما أنه لم يأت بعد “iPhone 3.” غير الموجود غير الموجود “iPhone 3.” لقد ارتكبت كل شيء تقريبًا. لقد اختبرته مع بعض الأسئلة الأساسية الأخرى ، لكن عدم الدقة استمرت.

بعد أن عانى Deepseek من خرق للبيانات ، شعرت بالطمأنينة لمعرفة أنه يمكنني تشغيل هذا النموذج محليًا دون القلق بشأن تعرض بياناتي. على الرغم من أنها ليست مثالية ، إلا أن وجود مساعد منظمة العفو الدولية غير متصل بالإنترنت هو ميزة كبيرة. أحب أن أرى المزيد من النماذج مثل هذه المدمجة في أجهزة المستهلكين مثل الهواتف الذكية ، وخاصة بعد خيبة أملي مع ذكاء Apple.