5 أشياء يجب ألا تشاركها مع AI chatbots

روابط سريعة

chatbots AI AI مدهشة ، لكن لا يمكننا التظاهر بأنها لا تشوبها شائبة. مع زيادة استخدامنا لمنظمة العفو الدولية ، من المهم للغاية أن نفهم أن بعض المعلومات يتم الاحتفاظ بها بشكل أفضل ولم يتم مشاركتها أبدًا مع chatbot AI.

مخاطر الخصوصية لدردشة الذكاء الاصطناعي

تحظى AI chatbots مثل ChatGPT و Google's Gemini بشعبية لأنها يمكن أن تولد استجابات تشبه الإنسان. ومع ذلك ، فإن اعتمادهم على نماذج اللغة الكبيرة (LLMS) يأتي مع مخاطر الخصوصية والأمن. تسلط هذه الثغرات الأمنية الضوء على كيفية تعرض المعلومات الشخصية المشتركة أثناء التفاعلات أو إساءة استخدامها.

- ممارسات جمع البيانات: تستخدم AI chatbots بيانات تدريب واسعة ، والتي قد تتضمن تفاعلات المستخدم. تتيح شركات مثل Openai للمستخدمين إلغاء الاشتراك في جمع البيانات ، ولكن قد يكون ضمان الخصوصية الكاملة أمرًا صعبًا.

- نقاط الضعف في الخادم: تعتبر بيانات المستخدم المخزنة عرضة لمحاولات الاختراق ، حيث يحتمل أن يسرق المجرمون الإلكترونية هذه المعلومات وأساء استخدامها لأغراض ضارة.

- وصول الطرف الثالث: يمكن مشاركة بيانات تفاعلات chatbot مع مقدمي خدمات الطرف الثالث أو الوصول إليها من قبل الموظفين المعتمدين ، مما يزيد من خطر الانتهاكات.

- لا استخدام الإعلان (المطالب به): بينما تدعي الشركات عدم بيع البيانات للتسويق ، يتم مشاركتها لأغراض صيانة النظام والتشغيلية.

- اهتمامات الذكاء الاصطناعي التوليدي: يجادل النقاد بأن الاعتماد المتزايد لوكالة الذكاء الاصطناعى التوليدي يمكن أن يؤدي إلى تفاقم مخاطر الأمن والخصوصية هذه.

إذا كنت ترغب في حماية بياناتك أثناء استخدام chatgpt وغيرها من chatbots من الذكاء الاصطناعي ، فإن الأمر يستحق فهم مخاطر الخصوصية التي تنطوي عليها. في حين توفر شركات مثل Openai بعض الشفافية والتحكم ، فإن تعقيدات مشاركة البيانات ونقاط الثغرات الأمنية تتطلب اليقظة.

لضمان خصوصيتك وأمانك ، هناك خمسة أنواع رئيسية من البيانات التي يجب ألا تشاركها أبدًا مع chatbot AI.

1. التفاصيل المالية

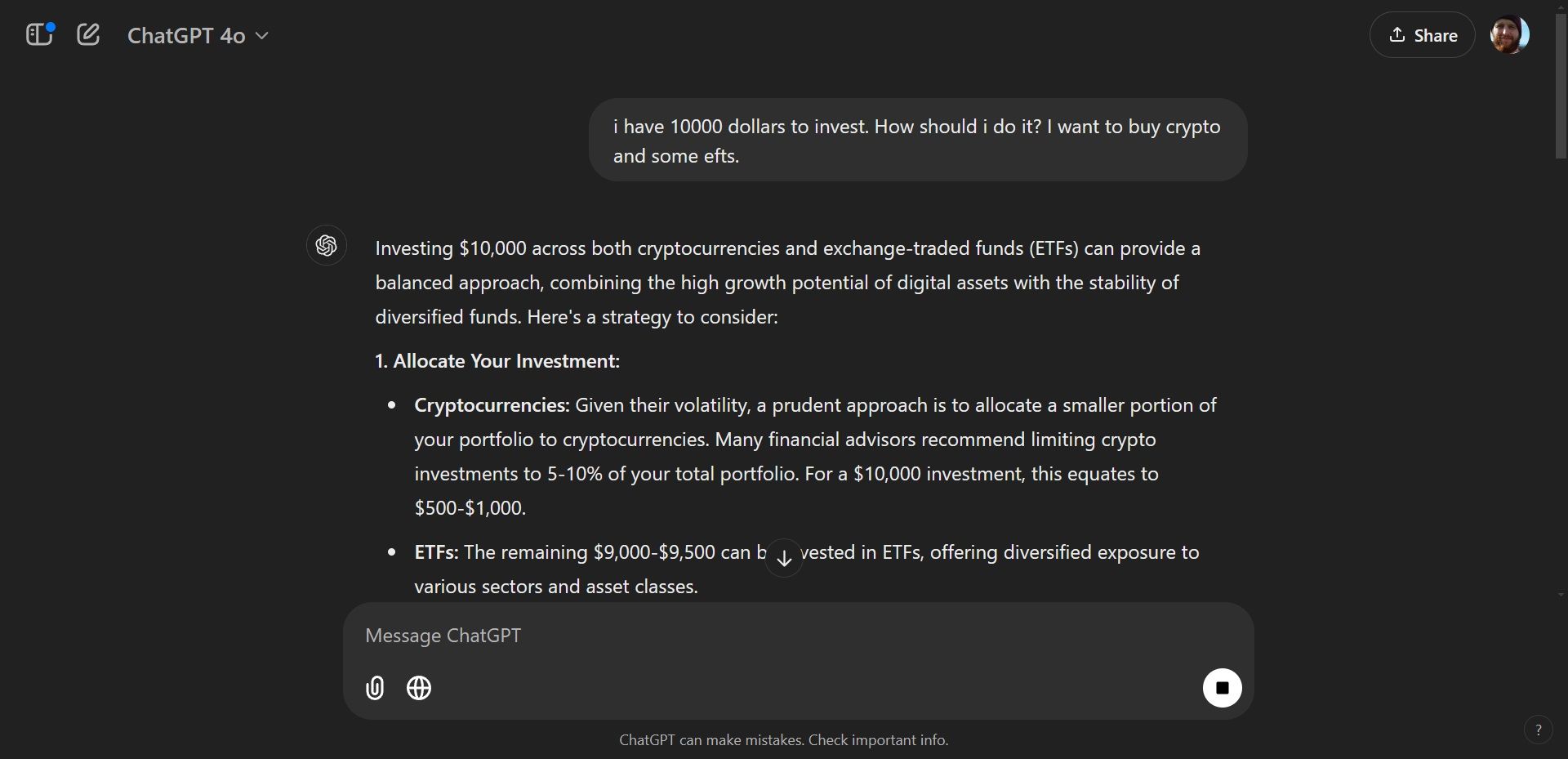

مع الاستخدام الواسع النطاق لـ AI chatbots ، تحول العديد من المستخدمين إلى نماذج اللغة هذه للحصول على المشورة المالية وإدارة الشؤون المالية الشخصية. على الرغم من أنها يمكن أن تعزز محو الأمية المالية ، إلا أن معرفة المخاطر المحتملة لمشاركة التفاصيل المالية مع AI chatbots أمر بالغ الأهمية.

عند استخدام chatbots كمستشارين ماليين ، فإنك تخاطر بتعريض معلوماتك المالية للمجرمين الإلكترونية المحتملين الذين يمكنهم استغلالها لتصريف حساباتك. على الرغم من أن الشركات التي تطالب ببيانات المحادثة مجهولة الهوية ، إلا أن أطراف ثالثة وبعض الموظفين قد لا يزالون يصلون إليها. على سبيل المثال ، قد يقوم chatbot بتحليل عادات الإنفاق الخاصة بك لتقديم المشورة ، ولكن إذا تم الوصول إلى هذه البيانات من قبل الكيانات غير المصرح بها ، فيمكن استخدامك لالتقاطك للاحتيال ، مثل رسائل البريد الإلكتروني المخادعة التي تحاكي البنك الخاص بك.

لحماية المعلومات المالية الخاصة بك ، قصر تفاعلاتك مع AI chatbots على المعلومات العامة والأسئلة الواسعة. يمكن لمشاركة تفاصيل الحساب المحددة أو تاريخ المعاملات أو كلمات المرور أن تتركك عرضة للخطر. المستشار المالي المرخص هو خيار أكثر أمانًا وموثوقية إذا كنت بحاجة إلى مشورة مالية مخصصة.

2. الأفكار الشخصية والحميمة

يلجأ العديد من المستخدمين إلى AI chatbots للبحث عن العلاج ، غير مدركين للعواقب المحتملة على رفاههم العقلي. يعد فهم مخاطر الكشف عن المعلومات الشخصية والحميمة لهذه الدردشة أمرًا ضروريًا.

تفتقر AI chatbots إلى معرفة العالم الحقيقي ويمكنها فقط تقديم ردود عامة على الاستفسارات المتعلقة بالصحة العقلية. هذا يعني أن الأدوية أو العلاجات التي يقترحونها قد لا تكون مناسبة لاحتياجاتك المحددة وقد تؤذي صحتك.

علاوة على ذلك ، فإن مشاركة الأفكار الشخصية مع AI chatbots تثير مخاوف خصوصية كبيرة. قد تتعرض خصوصيتك للخطر كأسرارك ، ويمكن تسريب الأفكار الحميمة عبر الإنترنت أو استخدامها كجزء من بيانات تدريب الذكاء الاصطناعى. يمكن للأفراد الخبيثين استغلال هذه المعلومات للتجسس عليك أو بيع بياناتك على الويب المظلم. لذلك ، من المهم حماية خصوصية الأفكار الشخصية عند التفاعل مع AI chatbots.

AI chatbots هي أدوات للمعلومات العامة والدعم بدلاً من بديل للعلاج المهني. إذا كنت بحاجة إلى مشورة أو علاج للصحة العقلية ، فاستشر أخصائي الصحة العقلية المؤهلة. يمكنهم تقديم إرشادات شخصية وموثوقة مع إعطاء الأولوية لمرضتك ورفاهيتك.

3. معلومات مكان العمل السرية

هناك خطأ آخر يجب على المستخدمين تجنبه عند التفاعل مع AI chatbots هو مشاركة المعلومات المتعلقة بالعمل السرية. قام عمالقة التكنولوجيا البارزة مثل Apple و Samsung و Google بتقييد موظفيها من استخدام AI chatbots في مكان العمل.

أ تقرير بلومبرج أبرزت حالة استخدم فيها موظفو Samsung ChatGPT لأغراض الترميز وتحميل رمز حساس عن غير قصد على منصة الذكاء الاصطناعى التوليدي. أسفر هذا الحادث عن الكشف غير المصرح به عن المعلومات السرية حول Samsung ، مما دفع الشركة إلى تطبيق حظر على استخدام AI chatbot. إذا كنت تستخدم الذكاء الاصطناعي لحل مشكلات الترميز (أو أي مشاكل أخرى في مكان العمل) ، فلن تثق في AI chatbots بمعلومات سرية.

وبالمثل ، يعتمد العديد من الموظفين على AI chatbots لتلخيص دقائق الاجتماع أو أتمتة المهام المتكررة ، مما يشكل خطر تعريض البيانات الحساسة عن غير قصد. يمكنك حماية المعلومات الحساسة وحماية مؤسستك من التسريبات غير المقصودة أو انتهاكات البيانات من خلال إدراك المخاطر المرتبطة بمشاركة البيانات المتعلقة بالعمل.

4. كلمات المرور

إن مشاركة كلمات المرور الخاصة بك عبر الإنترنت ، حتى مع نماذج اللغة الكبيرة ، هي عبارة عن حدوث مطلقة. تقوم هذه النماذج بتخزين البيانات على الخوادم ، والكشف عن كلمات المرور الخاصة بك لها تعرض خصوصيتك للخطر.

مهم خرق البيانات الذي يتضمن chatgpt حدث في مايو 2022 ، مما أثار مخاوف بشأن أمان منصات chatbot. علاوة على ذلك ، تم حظر Chatgpt في إيطاليا بسبب لائحة حماية البيانات العامة للاتحاد الأوروبي (GDPR). اعتبر المنظمون الإيطاليون أن AI chatbot غير متوافق مع قوانين الخصوصية ، مما يبرز مخاطر انتهاكات البيانات على المنصة. منذ فترة طويلة تم رفع الحظر ، لكنه يوضح أنه على الرغم من أن الشركات قد عززت تدابير أمن البيانات ، إلا أن نقاط الضعف لا تزال قائمة.

لحماية بيانات اعتماد تسجيل الدخول الخاصة بك ، لا تشاركها أبدًا مع chatbots ، حتى لأغراض استكشاف الأخطاء وإصلاحها. إذا كنت بحاجة إلى إعادة تعيين كلمات المرور أو إدارة كلمات المرور ، فاستخدم مديري كلمة المرور المخصصة أو بروتوكولات تكنولوجيا المعلومات الآمنة لمؤسستك.

5. التفاصيل السكنية والبيانات الشخصية الأخرى

تمامًا مثل وسائل التواصل الاجتماعي والمنصات الأخرى عبر الإنترنت ، يجب ألا تشارك أي معلومات تعريف شخصية (PII) مع chatbot منظمة العفو الدولية. يتضمن PII بيانات حساسة مثل موقعك ورقم الضمان الاجتماعي وتاريخ الميلاد والمعلومات الصحية ، والتي يمكن استخدامها لتحديد أو تحديد موقعك. على سبيل المثال ، فإن ذكر عنوان منزلك بشكل عرضي أثناء طلب chatbot للخدمات القريبة يمكن أن يعرضك عن غير قصد للمخاطر. إذا تم اعتراض هذه البيانات أو تسربها ، فيمكن لشخص ما استخدامها لسرقة الهوية أو تحديد موقعك في العالم الحقيقي. وبالمثل ، فإن الإفراط في المشاركة في المنصات المدمجة مع الذكاء الاصطناعى ، مثل Snapchat ، يمكن أن يكشف عن غير قصد عنك أكثر من المقصود.

للحفاظ على خصوصية بياناتك عند الانخراط مع AI chatbots ، إليك بعض الممارسات الرئيسية التي يجب متابعتها:

تعرف على سياسات خصوصية chatbots لفهم المخاطر المرتبطة بها.

تجنب طرح الأسئلة التي قد تكشف عن غير قصد عن هويتك أو معلوماتك الشخصية.

تمارس الحذر والامتناع عن مشاركة معلوماتك الطبية مع روبوتات الذكاء الاصطناعي.

تضع في اعتبارها نقاط الضعف المحتملة لبياناتك عند استخدام AI chatbots على المنصات الاجتماعية مثل Snapchat.

AI chatbots رائعة للعديد من الاستخدامات ، لكنها تشكل أيضًا مخاطر خصوصية خطيرة. إن حماية بياناتك الشخصية عند استخدام chatgpt أو copilot أو claude أو أي chatbot من الذكاء الاصطناعي الأخرى ليست صعبة بشكل خاص. فقط خذ لحظة للنظر في ما سيحدث إذا تم تسريب المعلومات التي تشاركها. بعد ذلك ، ستعرف ما الذي تتحدث عنه وما الذي ستحتفظ به لنفسك.