كيفية تثبيت أحدث نماذج اللغة الكبيرة (LLMS) محليًا على جهاز Mac الخاص بك

في السنوات الأخيرة ، أصبحت نماذج اللغة الكبيرة (LLMs) شائعة بشكل متزايد لقدرتها على توليد نص يشبه الإنسان والمساعدة في مهام مختلفة. ليست جميع الطرز مفتوحة المصدر ، ولكن كل شركة تكنولوجيا كبيرة لديها نسخة تسمح للمستخدمين بتنزيلها وتشغيلها.

يمكن أن يكون تشغيل هذه النماذج محليًا على جهاز Mac مفيدًا لأسباب الخصوصية والتكلفة. في هذه المقالة ، سنستكشف كيفية تثبيت وتشغيل LLMs باستخدام أولاما، أداة قوية للمطورين والمستخدمين المبتدئين ، ومناقشة بعض أدوات واجهة المستخدم الرسومية التي يمكن أن تبسيط العملية لأولئك الذين يفضلون عدم استخدام محطة MacOS.

وبهذه الطريقة ، يمكنك الوصول إلى أحدث نماذج نص AI من Google و Microsoft و META وغيرها من شركات الذكاء الاصطناعى مثل Mistral و Deepseek.

فهم LLMS: ماذا تعني المعلمات؟

قبل الغوص في عملية التثبيت ، دعنا نوضح ما هي أرقام مثل “7 ب” أو “14 ب“يعني عند الإشارة إلى LLMs. تمثل هذه الأرقام حجم النموذج من حيث حدود (مليارات) ، والتي هي أساسا “المقابض والمفاتيح” التي يتم ضبطها أثناء التدريب.

يتيح عدد أكبر من المعلمات للنموذج التقاط أنماط وعلاقات أكثر تعقيدًا في اللغة ، مما قد يؤدي إلى أداء أفضل. ومع ذلك ، من المهم ملاحظة أن المزيد من المعلمات لا تضمن دائمًا نتائج أفضل ؛ تلعب جودة بيانات التدريب والموارد الحسابية المتاحة للنموذج أدوارًا مهمة.

متطلبات النظام

سترغب في التأكد من أن جهاز Mac الخاص بك لديه المواصفات التالية على الأقل:

- MacOS 10.15 أو أحدث (MacOS 13 من أعلى الموصى بها)

- ما لا يقل عن 8 جيجابايت من ذاكرة الوصول العشوائي (16 جيجابايت أو أعلى الموصى بها)

- 10 جيجابايت من التخزين المجاني (الدقيقة مطلوبة لأصغر النماذج ؛ النماذج الأكثر تقدماً مع عدد أقصى عدد من المعلمات تصل إلى حوالي 700 جيجابايت)

- معالج Intel أو Apple Silicon متعدد النواة (M2 أو أفضل)

تثبيت Ollama

أولاما هي أداة مفتوحة المصدر تتيح لك تشغيل LLMs مباشرة على الجهاز المحلي الخاص بك. إليك كيفية البدء:

- تحميل Ollama: زيارة أولاما موقع ويب وقم بتنزيل إصدار MacOS. يمكنك أيضًا استخدام Homebrew للتثبيت عن طريق التشغيل

brew install ollamaفي المحطة الخاصة بك.

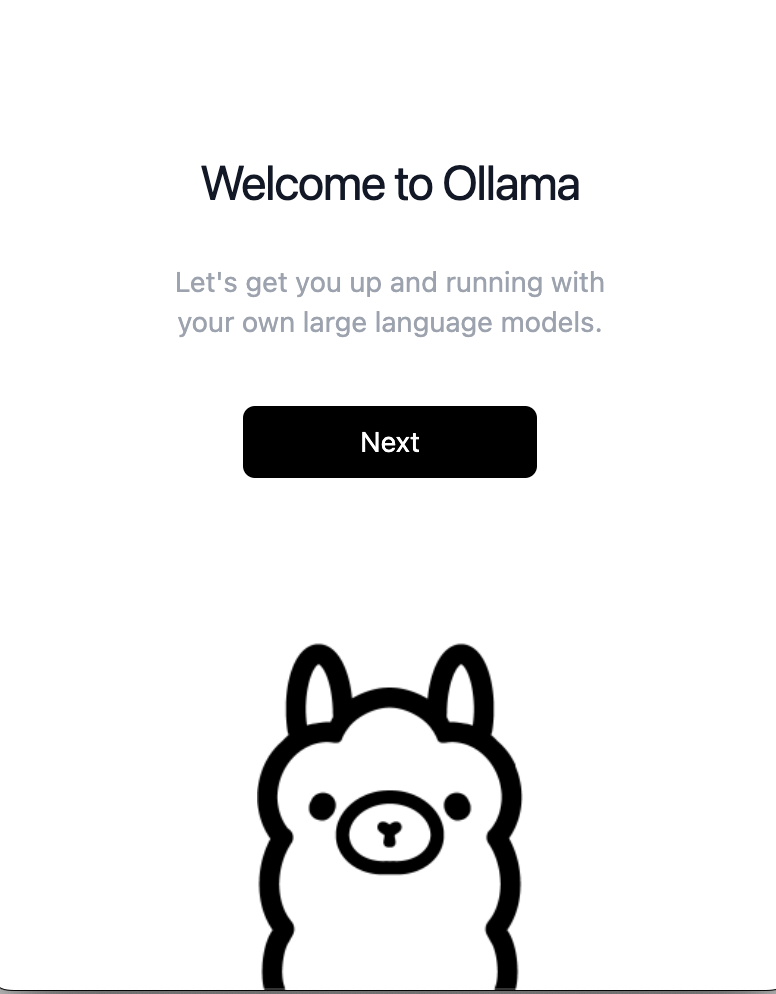

- تثبيت Ollama: إذا قمت بتنزيل المثبت ، ثم انقر نقرًا مزدوجًا فوقه ، واتبع معالج الإعداد. إذا كنت تستخدم homebrew ، تخطي إلى الخطوة 4.

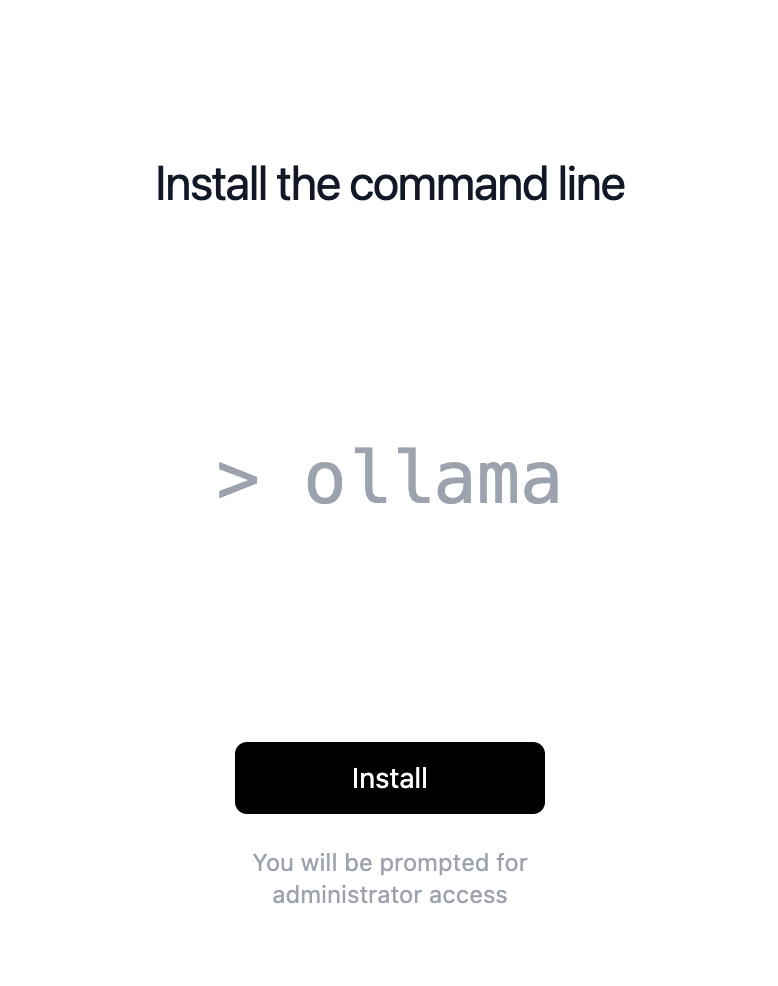

- الخطوة التالية للمثبت هي ببساطة النقر فوق ثَبَّتَ زر ، والذي سيطلب كلمة مرور المسؤول.

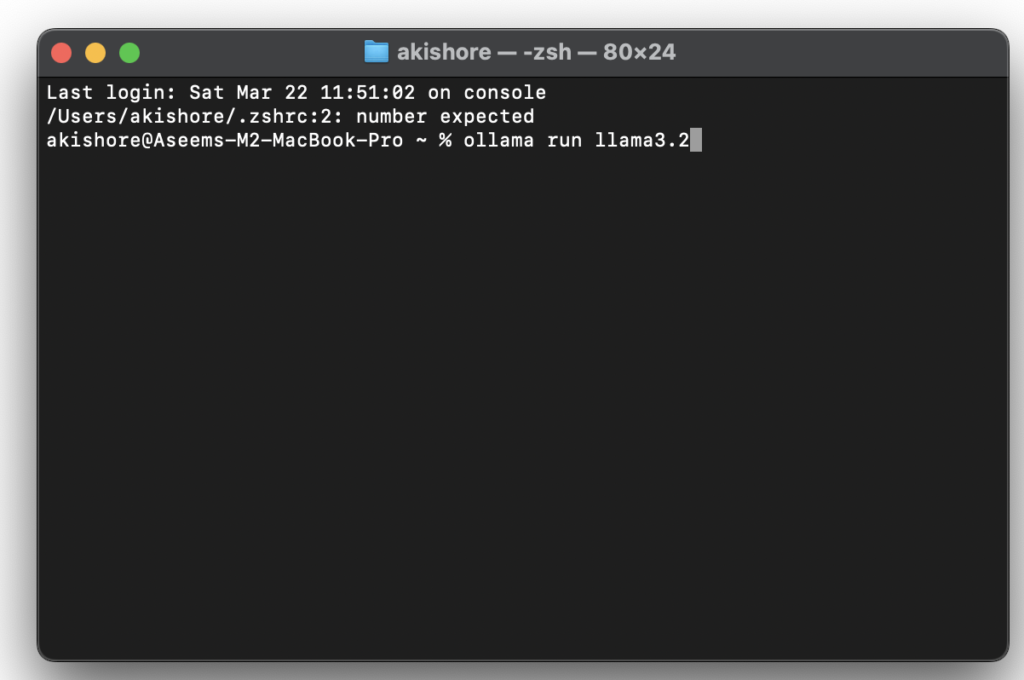

- تشغيل أولاما: افتح محطة وابدأ Ollama كخدمة مع

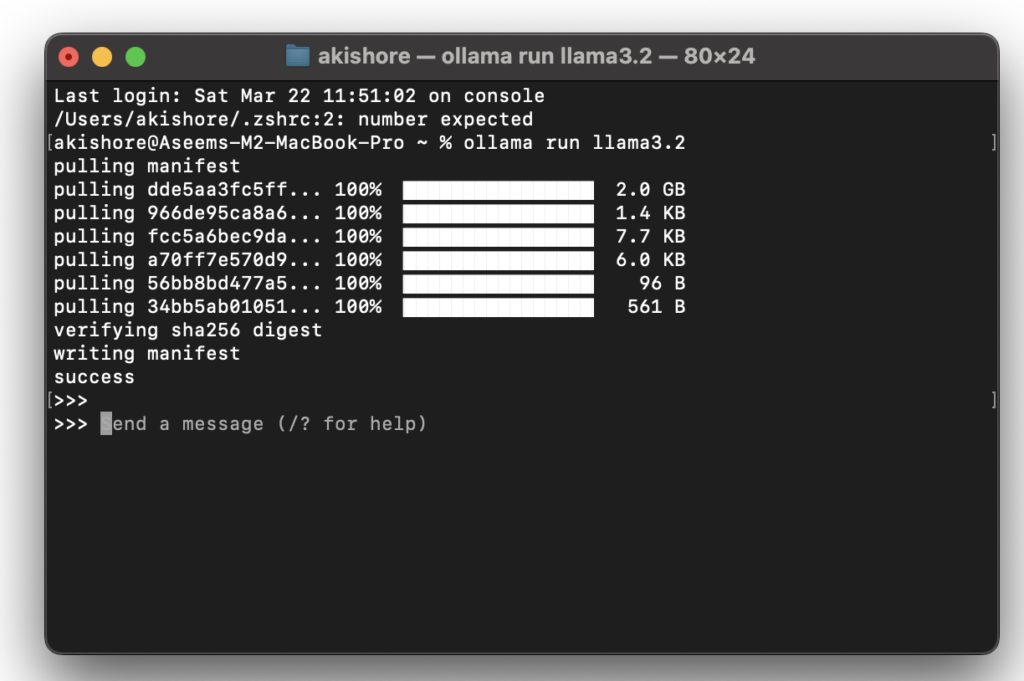

brew services start ollama. هذا سيجعل أولاما متاحًا فيhttp://localhost:11434/. - تنزيل وتشغيل نموذج: استخدم الأمر

ollama pull <model-name>لتنزيل نموذج ، ثمollama run <model-name>لتشغيله. على سبيل المثال ، لتشغيل Deepseek-R1 نموذج ، الاستخدامollama pull deepseek-r1تليهاollama run deepseek-r1. - لتنزيل نسخة معلمة أكبر من نموذج ، ما عليك سوى إضافة قولون متبوعًا بالحجم. على سبيل المثال ، لتنزيل 14B Deepseek نموذج، سوف تستخدم Ollama Run Deepseek-R1: 14b يأمر. على موقع Ollama ، موقع الويب ، يمكنك النقر على أي من النماذج وسيظهر لك جميع الأوامر المختلفة لكل إصدار.

يمكنك العثور على القائمة الكاملة لـ نماذج لأولاما هنا. يمكنك أيضًا استخدام الأمر الثاني كما هو موضح أعلاه ، وإذا لم يتم تثبيته بالفعل ، فسوف يسحب النموذج أولاً ثم تشغيله.

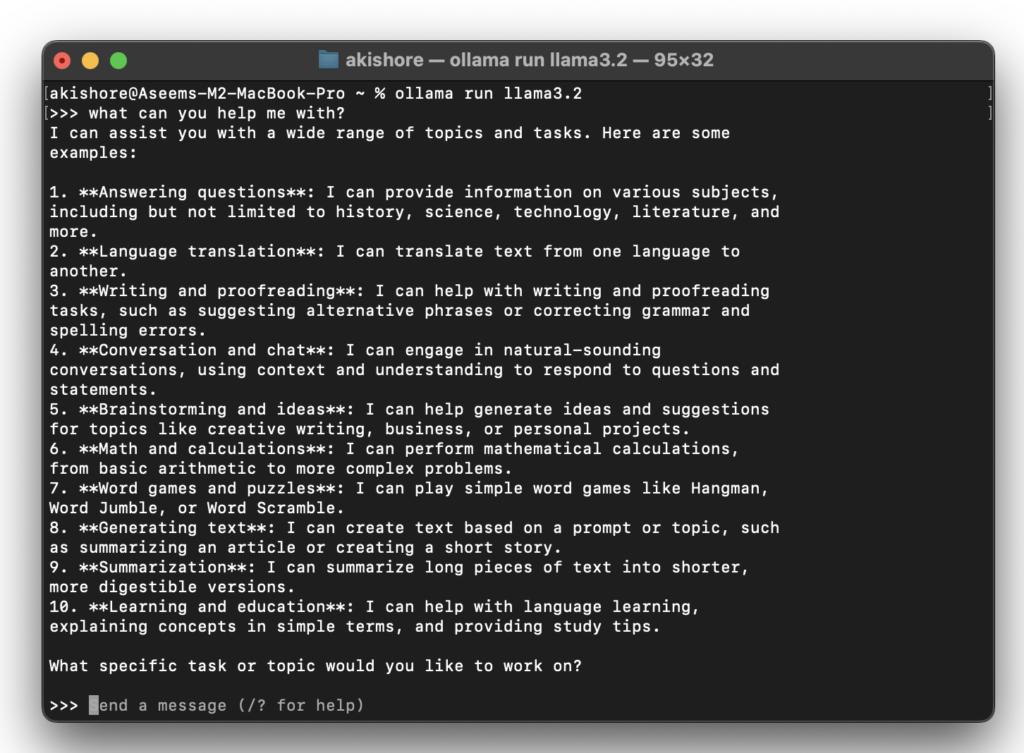

الآن عندما ترى الأسهم الثلاثة اليمنى (>>>) ، يمكنك البدء في كتابة الأوامر إلى النموذج.

هذا كل شيء! يمكنك الآن التفاعل محليًا مع LLM الخاص بك ولا داعي للقلق بشأن التكاليف ، أو الإفراط في استخدامها ، أو أنه يمكن للأشخاص الآخرين قراءة ما تكتبه. هذا أمر رائع إذا كان لديك بعض الموضوعات الحساسة أو الشخصية التي ترغب في مناقشتها مع AI LLM ، ولكن لا تريد شركة تقنية كبيرة تقرأ أفكارك.

باستخدام أدوات واجهة المستخدم الرسومية مع Ollama

على الرغم من أن Ollama قوي وفعال للمطورين ، فقد يفضل بعض المستخدمين واجهة مستخدم رسومية (GUI) للتفاعل مع LLMS. فيما يلي بعض الأدوات التي يمكن أن توفر واجهة واجهة المستخدم الرسومية لأولاما:

- أولاما واجهة المستخدم الرسومية: هذا تطبيق مجاني ومفتوح المصدر لمستخدمي MacOS الذي تم إنشاؤه باستخدام Swiftui. إنه يوفر واجهة جميلة وهو خيار ممتاز لأولئك الذين يرغبون في الوصول إلى LLMs محليًا دون استخدام المحطة.

- Ollama UI: واجهة مستخدم ويب بسيطة تستند إلى HTML والتي تتيح لك تحديد النماذج والتفاعل معها مباشرة في متصفحك. ويشمل أيضًا امتداد كروم لسهولة الوصول إليه.

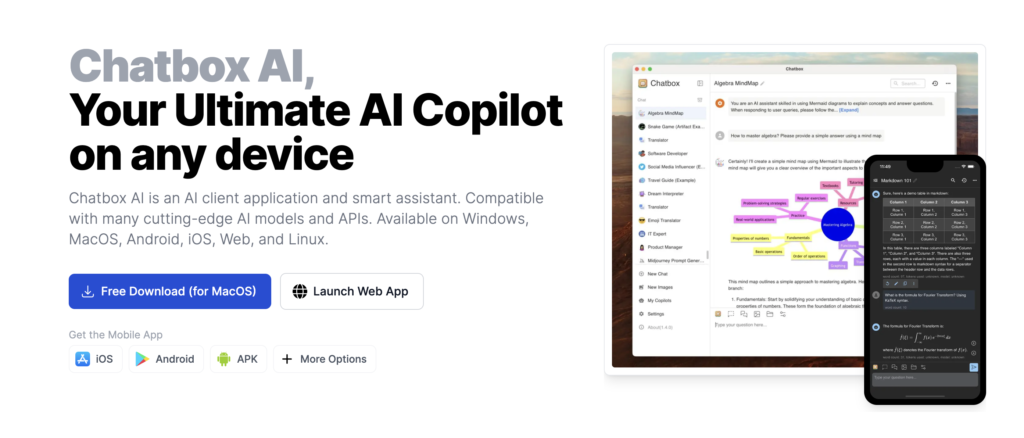

- chatbox ai: هذا هو الأسهل للمبتدئين والطويلة التي أشرح كيفية استخدامها أدناه. لاحظ أنك لا تحتاج إلى الحصول على خدمة Chatbox AI ، وهو اشتراك يقدمونه حتى تتمكن من الوصول إلى جميع LLMs دون الحاجة إلى تثبيت Ollama بنفسك.

لاستخدام واجهة AI Bostbox ، انتقل إلى صفحة التنزيل واحصل على الإصدار ل MAC الخاص بك.

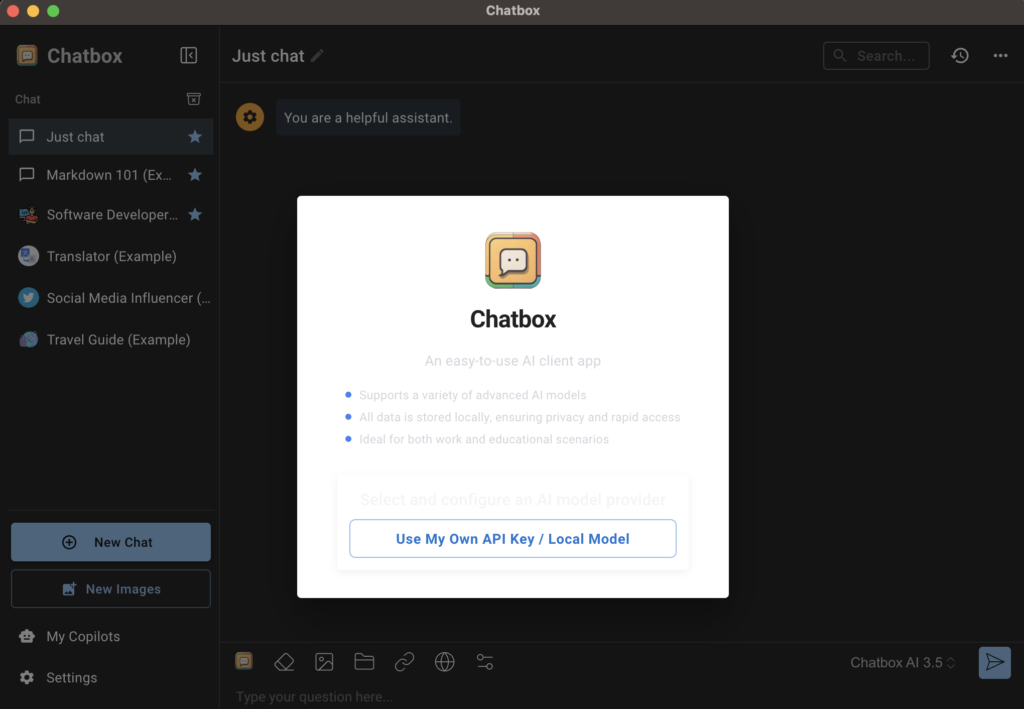

بعد ذلك ، افتح المثبت وقم بتشغيل البرنامج. على الشاشة الأولى ، ستظهر نافذة منبثقة تسأل كيف تريد استخدام chatbox ai.

سترغب في النقر فوق استخدم مفتاح API الخاص بي / النموذج المحلي زر.

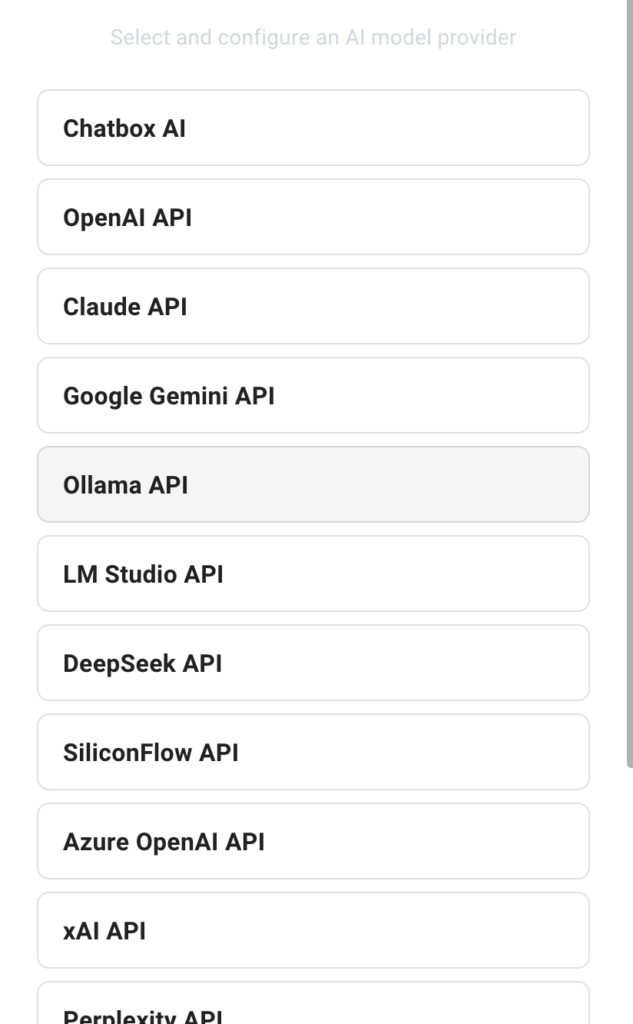

التالي ، انقر فوق Ollama API كمزود نموذج الذكاء الاصطناعى.

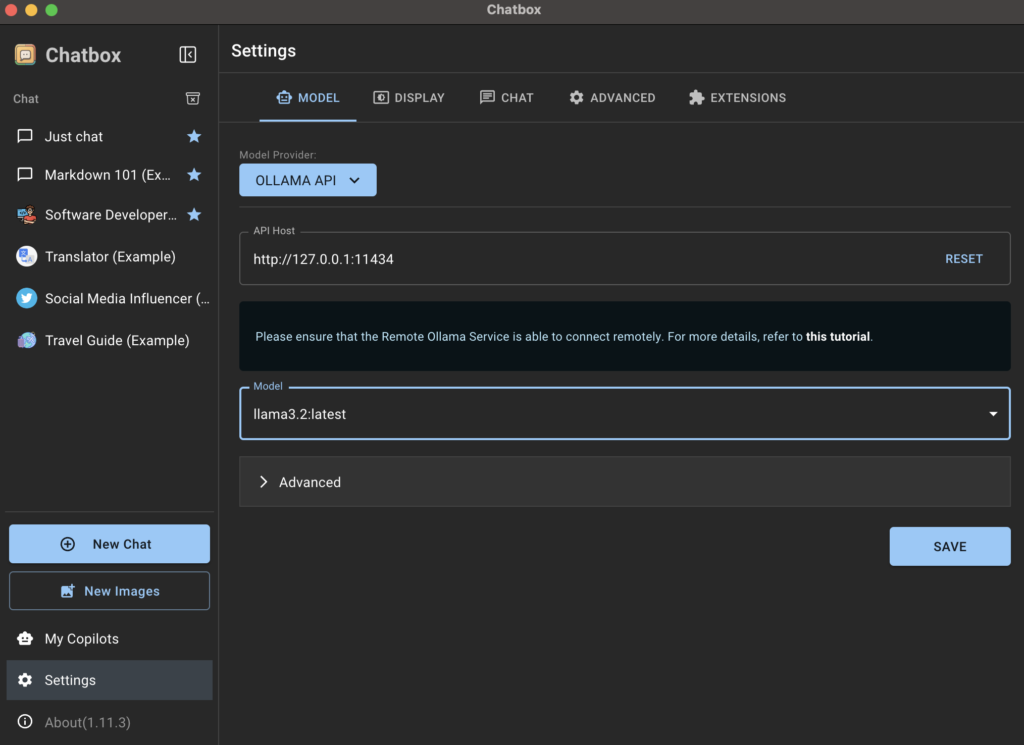

يجب أن يكتشف Tatbox AI تلقائيًا أن Ollama يعمل ويقوم بتعيين مضيف API على القيمة الافتراضية ، وهو عنوان IP الخاص بك ورقم المنفذ 11434. ليس عليك تغيير أي شيء هنا. ضمن النموذج ، يجب أن ترى النماذج التي قمت بتثبيتها سابقًا باستخدام Terminal. في حالتي ، إنها لاما 3.2 نموذج.

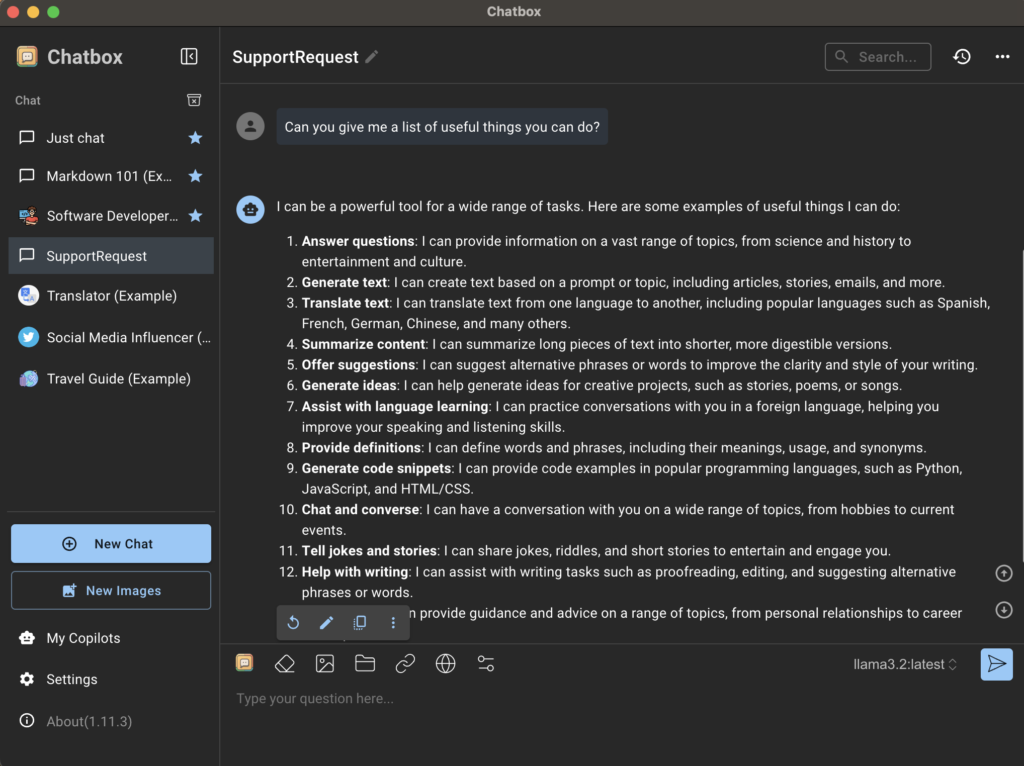

مرة أخرى على الصفحة الرئيسية للتطبيق ، انقر فوق فقط الدردشة أو دردشة جديدة وتأكد من تحديد النموذج الصحيح أسفل أسفل اليمين. يمكنك تغيير النموذج في أي وقت ، لكنني أوصي بإنشاء محادثة جديدة لكل طراز تستخدمه حتى تتمكن من رؤية الاختلافات بسهولة.

أدوات بديلة لتشغيل LLMS محليًا

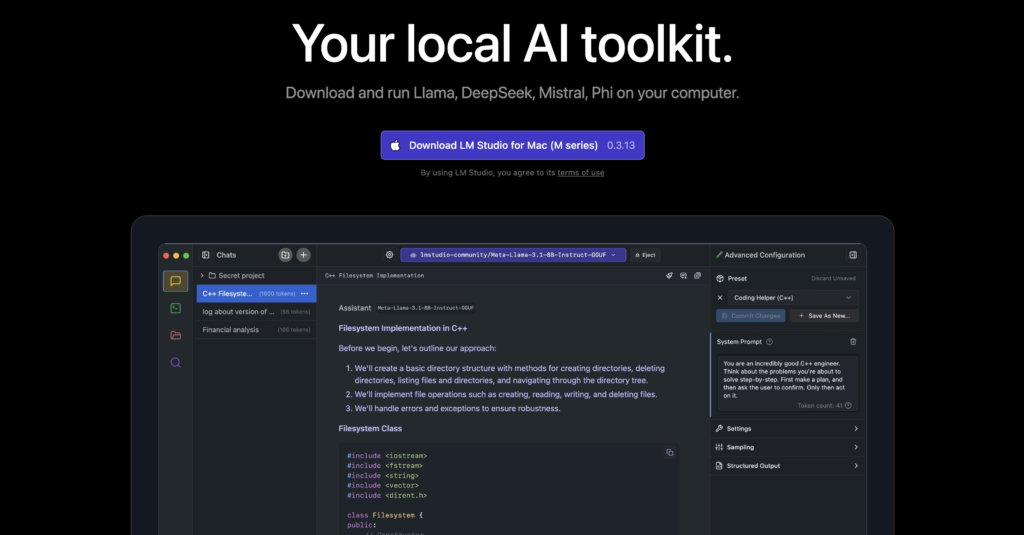

إذا كنت تبحث عن بدائل لـ Ollama أو تفضل تجربة أكثر سهولة في البداية من البداية ، استوديو LM هو خيار ممتاز آخر. يوفر واجهة بديهية لاستكشاف واستخدام نماذج الذكاء الاصطناعي المختلفة ، مما يتيح لك تنزيل النماذج وتشغيلها بسهولة. يتوفر LM Studio على Linux و Mac و Windows ويقدم ميزات مثل تخصيص المعلمة النموذجية وتاريخ الدردشة. إنه مجاني في الوقت الحالي ، ولهذا السبب أوصي به على اشتراك خدمة Chatbox AI.

خاتمة

سيكون تشغيل نماذج اللغة الكبيرة محليًا على جهاز Mac أمرًا مهمًا لأي شخص يتطلع إلى الحصول على مزيد من التحكم في تطبيقات الذكاء الاصطناعى الخاص به وإعطاء الأولوية خصوصية البيانات. مع الأدوات مثل Ollama و GUI Frontends المذكورة مما يجعل من السهل دمج LLMs في سير العمل الخاص بك ، يمكنك فتح إمكانيات جديدة بشكل آمن للإنتاجية والإبداع.

ومع ذلك ، فإن البدء في نشر LLM المحلي يتطلب بعض الفهم للمعلمات وكيف تؤثر على أداء هذه النماذج على أجهزتك المحددة. أفضل طريقة لمعرفة ذلك هي من خلال اللعب مع النماذج المختلفة لمعرفة أي شخص يعطيك أفضل النتائج. بمجرد أن تفهم هذا المفهوم ، ستتمكن من اتخاذ قرارات أفضل حول النماذج التي يجب استخدامها وكيفية تحسين أدائها لاحتياجاتك الخاصة.

الوظائف ذات الصلة

كيفية إصلاح خطأ 500 خادم داخلي على الحرف AI

كيفية إخفاء أو إزالة copilot من شريط المهام Windows 11

ما هو Windows AI Copilot؟

كيفية توصيل براعم Samsung Galaxy بجهاز Windows أو Mac Computer

كيفية إعادة تسمية أجهزة Bluetooth في Windows و Android و iOS و Mac